Spis treści

Dlaczego elastyczność we wdrożeniu AI jest kluczowa dla firm

Sztuczna inteligencja staje się fundamentem cyfrowej transformacji przedsiębiorstw. Od automatyzacji procesów biurowych, przez analizę danych, aż po wsparcie strategicznych decyzji – jej rola stale rośnie. Jednak wraz ze wzrostem możliwości rosną także oczekiwania dotyczące bezpieczeństwa, zgodności z regulacjami i efektywności kosztowej.

65% firm wskazuje bezpieczeństwo danych jako największą barierę dla dalszej adopcji AI (McKinsey 2024). Z kolei prognozy Gartnera mówią, że do 2026 roku 75% dużych organizacji wdroży hybrydowe modele AI, łączące chmurę publiczną, prywatne środowiska i architekturę RAG.

To właśnie dlatego elastyczność wdrożeniowa staje się czynnikiem kluczowym – różne branże wymagają różnych podejść, a jedno uniwersalne rozwiązanie po prostu nie istnieje.

Największe wyzwania przy wdrażaniu AI w firmie

Wiele firm przed rozpoczęciem projektu AI mierzy się z wyzwaniami, które blokują efektywne wykorzystanie technologii. Najczęściej pojawiają się obawy o bezpieczeństwo danych i zgodność z regulacjami, brak kompetencji wewnętrznych w obszarze MLOps oraz niepewność co do kosztów długoterminowych. Dodatkowo w dużych organizacjach pojawia się problem integracji rozproszonych systemów i baz wiedzy, co bezpośrednio wpływa na jakość działania modeli językowych.

Integracja AI w firmie – architektura, API i bezpieczeństwo

Integracja sztucznej inteligencji z istniejącymi procesami biznesowymi wymaga przemyślanej architektury. Rozwiązania chmurowe (np. Copilot, ChatGPT) zwykle integrują się poprzez gotowe wtyczki i API, co skraca czas wdrożenia. Prywatne modele LLM również oferują dostęp przez API. Dodatkową trudnością pozostaje konieczność utrzymania infrastruktury serwerowej dla samego modelu, jednak pozostałe elementy integracji — takie jak zarządzanie danymi, uwierzytelnianie, logika biznesowa czy interfejsy użytkownika — są zbliżone zarówno dla rozwiązań chmurowych, jak i prywatnie hostowanych LLM.

W przypadku RAG kluczowe jest wdrożenie zaawansowanego systemu OCR, wektorowej bazy danych i przygotowanie pipeline’u, który pozwala na aktualizację treści w czasie rzeczywistym. Tylko dobrze zaprojektowana integracja sprawia, że AI działa nie jako „dodatek”, lecz jako spójny element systemu informatycznego.

Copilot i ChatGPT – jak szybko wdrożyć AI w firmie z chmury

Rozwiązania takie jak Microsoft Copilot czy ChatGPT pozwalają rozpocząć korzystanie z AI w ciągu kilku dni, bez inwestycji w infrastrukturę. Dostęp do modeli GPT-4o, GPT-5 zapewnia najwyższą jakość generowanych treści, a ekosystem integracji sprawia, że AI staje się naturalnym rozszerzeniem codziennych narzędzi biznesowych.

Jednocześnie należy pamiętać, że organizacja korzystająca z usług chmurowych jest w pełni zależna od dostawcy – zarówno w zakresie przechowywania danych, jak i polityki cenowej. W branżach regulowanych ryzyko związane z przetwarzaniem danych w chmurze często uniemożliwia pełne wykorzystanie potencjału tych rozwiązań.

Prywatne LLM – pełna kontrola i zgodność z regulacjami

Prywatnie hostowane modele LLM (np. LLaMA, Mistral, Gemini, Falcon czy polski Bielik) to odpowiedź na potrzeby organizacji, które wymagają pełnej kontroli nad przetwarzaniem danych. Uruchamiane lokalnie (on-premise) lub w prywatnej chmurze pozwalają na dostosowanie architektury do wymogów branżowych i prawnych.

Ich największym atutem jest to, że zapewniają zgodność z regulacjami (RODO, HIPAA) i umożliwiają fine-tuning pod kątem procesów biznesowych. To rozwiązanie wybierają banki, instytucje publiczne i sektor medyczny – wszędzie tam, gdzie ochrona danych i zgodność regulacyjna mają absolutny priorytet.

RAG – inteligentne połączenie modelu z wiedzą firmy

Coraz częściej wybieranym podejściem jest RAG (Retrieval-Augmented Generation). W tej architekturze LLM działa jako warstwa językowa, natomiast odpowiedzi generowane są na podstawie wewnętrznych danych przedsiębiorstwa.

Mechanizm działania jest następujący: zapytanie użytkownika uruchamia wyszukiwanie w wektorowej bazie danych (np. Pinecone, Weaviate, FAISS), a odpowiednie fragmenty dokumentów są dynamicznie włączane do kontekstu modelu. Dzięki temu system zapewnia aktualność, precyzję i możliwość elastycznej wymiany modelu LLM, bez potrzeby budowania całej architektury od nowa.

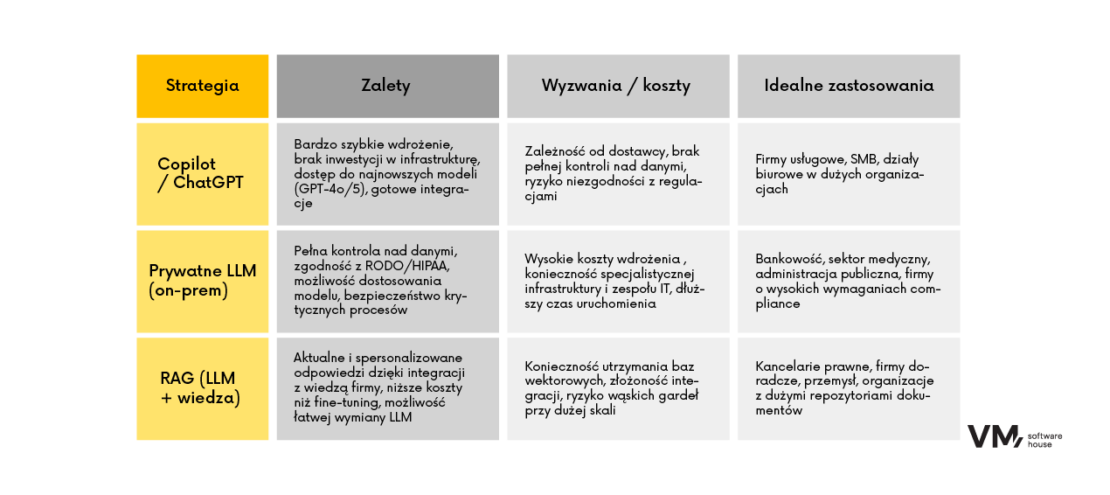

Porównanie strategii wdrożenia AI – Copilot, LLM i RAG

Gotowe rozwiązania AI dla firm – od Copilot po RAG i LLM

Jako dostawca rozwiązań AI oferujemy pełne spektrum możliwości wdrożeniowych. Wdrażamy Copilot i ChatGPT Enterprise, pomagając firmom szybko rozpocząć korzystanie ze sztucznej inteligencji. Budujemy także prywatne instalacje LLM uruchamiane zarówno w chmurze prywatnej, jak i on-premise, dla organizacji o szczególnych wymaganiach regulacyjnych. Naszą specjalnością są systemy RAG z wymienną warstwą LLM, które pozwalają na zachowanie elastyczności i pełnej kontroli nad danymi.

Stosujemy architekturę modularną, która umożliwia łatwą wymianę modeli, zapewniamy pełne bezpieczeństwo i zgodność z regulacjami, a także optymalizujemy koszty wdrożenia dzięki dopasowaniu technologii do potrzeb biznesowych.

Przykładem jest projekt wdrożony w sektorze prawnym, gdzie opracowaliśmy system RAG oparty na modelu Mistral i prywatnej bazie wiedzy klienta. W rezultacie czas przygotowania analiz dokumentów skrócił się o 35%, przy jednoczesnym zachowaniu pełnej zgodności z polityką bezpieczeństwa danych.

Dodatkową zaletą modularności opracowanego przez nas systemu, jest możliwość zastosowania różnych rozwiązań w warstwie UI. Może to być strona www, aplikacja Teams, asystent głosowy lub integracja z MS Copilot.

Jak wybrać optymalną ścieżkę wdrożeniową

Wybór właściwej strategii AI powinien być poprzedzony analizą kluczowych czynników. Organizacje muszą uwzględnić charakter danych, wymogi regulacyjne, dostępny budżet oraz priorytety biznesowe. Firmy, które potrzebują szybkiego efektu, mogą skorzystać z gotowych usług chmurowych. Tam, gdzie nadrzędne znaczenie ma zgodność z regulacjami i pełna kontrola – sprawdzą się prywatne modele. Natomiast przedsiębiorstwa, które chcą łączyć moc modeli językowych z własną dokumentacją, powinny rozważyć architekturę RAG.

Dlaczego elastyczność we wdrożeniu AI (Copilot, ChatGPT, LLM, RAG) ma kluczowe znaczenie

Elastyczność wdrożeniowa to fundament skutecznej transformacji AI w organizacjach. Nie ma jednej uniwersalnej ścieżki – różne firmy wybierają różne modele, w zależności od potrzeb. Rozwiązania chmurowe dają szybkość, prywatne LLM gwarantują kontrolę, a systemy RAG zapewniają najbardziej praktyczne połączenie aktualnych danych z możliwościami modeli językowych.

RAG staje się standardem rynkowym, ale każda organizacja potrzebuje indywidualnego podejścia. Dlatego wspieramy firmy w projektowaniu i wdrażaniu architektury AI dopasowanej do ich wymagań, od proof-of-concept, przez integrację, aż po pełne środowiska produkcyjne.

Skontaktuj się z nami, aby wspólnie zaplanować elastyczne wdrożenie AI – od szybkiego startu z Copilot, przez prywatne modele LLM, aż po systemy RAG dostosowane do Twojej firmy.