Czy wiesz, że według Departamentu Pracy w USA do końca 2023 roku wskaźnik zatrudnienia programistów, analityków jakości i testerów ma wzrosnąć o 25%? Pokazuje to znaczenie zapewnienia jakości w branży oprogramowania i ciągłe wysiłki na rzecz poprawy praktyk QA. Ale jak wcielić kompleksowe podejście do procesu tworzenia doskonałego oprogramowania? Jest to wynik zbudowania pomostu między wizją programistów a oczekiwaniami użytkowników końcowych.

W cyfrowym krajobrazie, który ewoluuje szybciej, niż jesteśmy w stanie to zauważyć, pojawia się wiele wyzwań związanych z jakością oprogramowania. Statystyki z 2023 roku podkreślają, że zapewnienie jakości stanowi gwarancję zadowolenia użytkowników. Według

TestDevLab Report 2023, głównym celem 80% firm z branży IT będzie poprawa istniejących procesów i praktyk z zakresu QA. Co więcej, ponad trzy czwarte badanych firm ujawniło, że testy automatyczne będą ważnym podejściem w zakresie testowania oprogramowania wdrożonym w ich organizacjach, a dla 73% respondentów testy manualne pozostaną nadal ważną częścią tego procesu.

W tym artykule omówimy najlepsze praktyki, które zapewnią nie tylko wysoką jakość oprogramowania, ale także pozwolą na ciągłe doskonalenie procesów jego wytwarzania.

Na czym polega rola Quality Assurance w tworzeniu oprogramowania?

Quality Assurance (QA) w rozwoju oprogramowania to

systematyczny proces, zapewniający jakość, niezawodność i wydajność aplikacji. Obejmuje on szereg działań i metod mających na celu zapobieganie powstawaniu błędów i problemów w wytwarzanym oprogramowaniu. Jest to aktywny proces, który ma swój początek już w początkowych etapach tworzenia oprogramowania i jest kontynuowany przez cały cykl jego życia. Odgrywa kluczową rolę w dostarczaniu oprogramowania, tak by spełniło oczekiwania użytkowników.

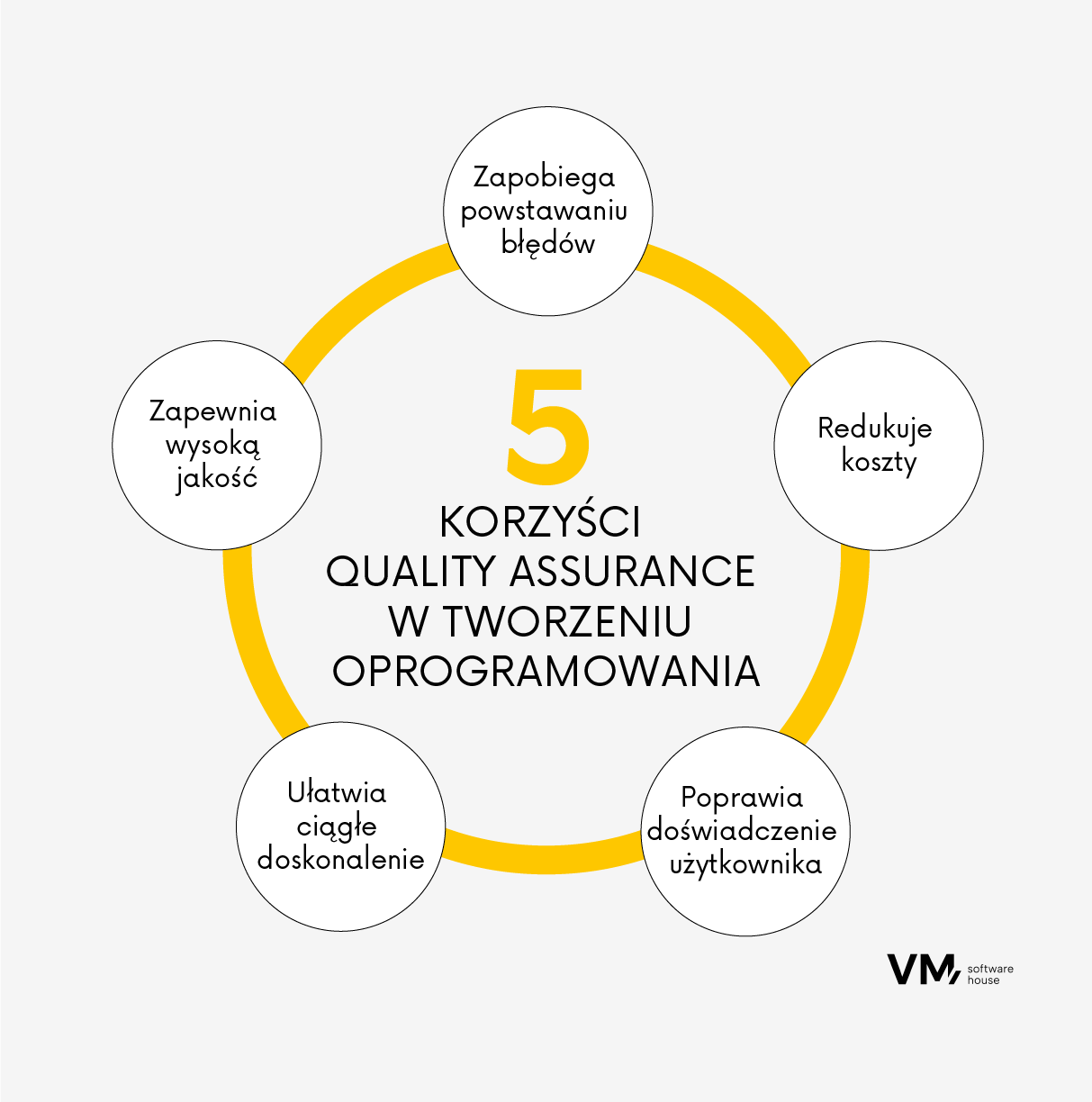

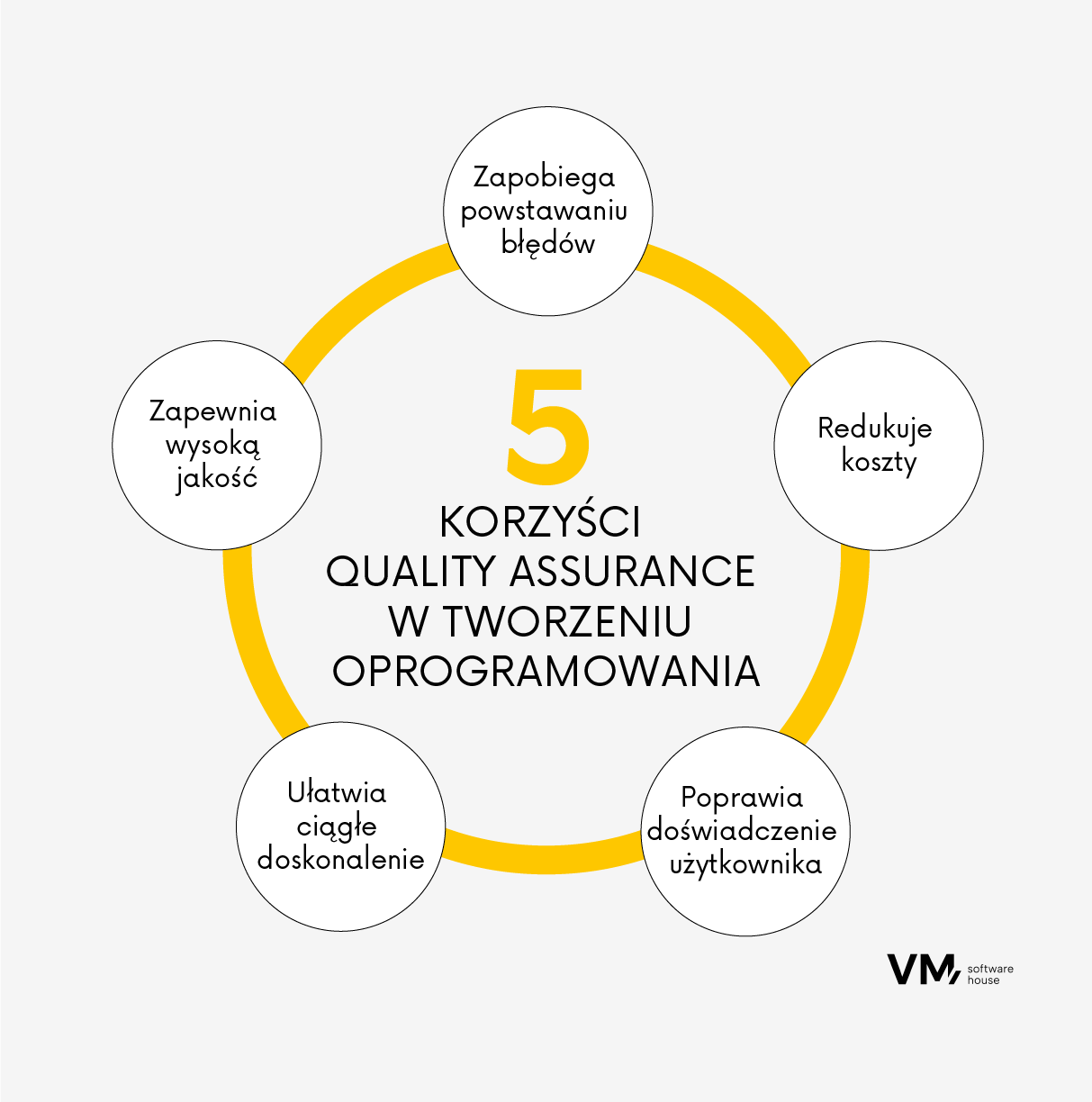

Poniżej przedstawiamy, jakie są tego korzyści:

- Zapewnia wysoką jakość: QA obejmuje systematyczne działania zmierzające do uzyskania pewności, że tworzone oprogramowanie odpowiada oczekiwaniom klientów. Składają się na nie między innymi takie elementy jak analiza wymagań, weryfikacja projektu, przegląd kodu, testowanie i inne.

- Zapobiega powstawaniu błędów: QA koncentruje się na zapobieganiu powstawaniu błędów jeszcze przed ich wystąpieniem. Identyfikuje potencjalne problemy i zagrożenia na wczesnym etapie procesu rozwoju, umożliwiając zespołom zajęcie się nimi, zanim przerodzą się w większe problemy.

- Redukuje koszty: Poprzez wczesne wychwytywanie potencjalnych błędów, QA pomaga zminimalizować koszty związane z ich usuwaniem na późniejszych etapach procesu rozwoju, gdy często są one wyższe i bardziej czasochłonne. Poprzez zapobieganie powstawaniu błędów, QA może pomóc w utrzymaniu terminowości i budżetu projektu. Pomaga również zadbać o to, by oprogramowanie było zgodne ze wszystkimi niezbędnymi przepisami, co pozwala uniknąć kosztów związanych z karami za nieprzestrzeganie przepisów prawnych.

- Poprawia doświadczenie użytkownika: Analiza jakości sprawia, że tworzone oprogramowanie jest łatwe w obsłudze, niezawodne, wydajne i spełnia stawiane mu wymagania. Zwiększa to zadowolenie i lojalność użytkowników.

- Ułatwia ciągłe doskonalenie: QA obejmuje regularne przeglądy i audyty procesów i wydajności oprogramowania. Pomaga to zespołom zidentyfikować obszary wymagające poprawy, wyciągać wnioski z popełnionych błędów i stale podnosić jakość swojej pracy.

Różnica między jakością a ilością kodu

Ilość wyprodukowanego kodu i jego jakość to dwa różne aspekty tworzenia oprogramowania. Ilość kodu możemy mierzyć na różne sposoby, takie jak linijki kodu, liczba funkcjonalności, modułów lub klas. Jednak większa ilość kodu niekoniecznie oznacza lepsze oprogramowanie, lecz wręcz może sprawić, że będzie ono bardziej skomplikowane i trudniejsze w utrzymaniu.

Jakość kodu oznacza możliwość określenia, w jakim stopniu kod jest poprawnie napisany i jak dalece skutecznie spełnia swoją funkcję. Kod wysokiej jakości jest zazwyczaj:

- Czytelny: Jest łatwy do zrozumienia dla innych programistów, co ułatwia konserwację i przyszłe aktualizacje.

- Łatwy w utrzymaniu: Jest zorganizowany i modułowy, co ułatwia jego aktualizację lub modyfikację.

- Wydajny: Wykonuje zamierzone działanie bez marnowania zasobów.

- Niezawodny: Działa poprawnie w rozmaitych warunkach i z uwzględnieniem określonych parametrów.

- Bezpieczny: Nie posiada luk w zabezpieczeniach, które mogłyby zostać wykorzystane przez atakujących.

Podczas gdy ilość kodu jest miarodajnym aspektem rozwoju oprogramowania, to jakość kodu jest elementem, który ostatecznie definiuje dostarczaną przez nie wartość. Wysokiej jakości kod może sprawić, że oprogramowanie będzie działać sprawniej, bezpieczniej i że będzie ono łatwiejsze w utrzymaniu i aktualizacji.

15 najlepszych praktyk zapewniania jakości oprogramowania

1. Dokładna analiza wymagań

Analiza wymagań to

proces zrozumienia, czego użytkownicy końcowi potrzebują od tworzonego oprogramowania. Obejmuje to ich wymagania funkcjonalne (jakie funkcje, czynności, operacje, usługi są wykonywane przez system) i niefunkcjonalne (ograniczenia lub wymagania nałożone na system określające atrybut jakości).

Oprócz potrzeb użytkowników, analiza wymagań uwzględnia szersze cele biznesowe.

Daje pewność, że oprogramowanie jest zgodne ze strategicznymi celami organizacji, przyczyniając się do jej sukcesu. Analiza wymagań pomaga ustalić priorytety cech i funkcjonalności w oparciu o potrzeby użytkowników, zapewniając, że oprogramowanie dostarcza to, co jest dla nich najbardziej istotne.

Szczegółowa analiza wymagań

minimalizuje również ryzyko kosztownych zmian w połowie projektu, oszczędzając czas i zasoby. Z kolei niezrozumienie lub błędna interpretacja wymagań może prowadzić do kosztownych zmian i opóźnień w trakcie rozwoju. Identyfikując potencjalne zagrożenia na wczesnym etapie analizy wymagań, zespoły programistyczne mogą je skutecznie planować i łagodzić. Takie proaktywne podejście zmniejsza szanse na pojawienie się nieoczekiwanych problemów podczas tworzenia oprogramowania, podnosząc tym samym jego jakość.

2. Test-Driven Development (TDD)

Test-Driven Development (TDD) to podejście do tworzenia oprogramowania, w którym t

esty są pisane przed faktycznym kodem. Podąża za prostym procesem iteracyjnym: najpierw napisz test, potem napisz kod, aby test przeszedł pomyślnie, a następnie refaktoryzuj kod do akceptowalnych standardów. Cykl powtarza się wraz z nowymi testami.

Niektóre z zalet TDD to:

- Wczesne wykrywanie błędów: Ponieważ testowanie odbywa się równolegle z rozwojem, błędy i problemy mogą zostać zidentyfikowane na wczesnym etapie, co zmniejsza koszty i wysiłek związany z ich późniejszym naprawianiem.

- Poprawa projektu: Pisanie testów w pierwszej kolejności wymaga zastanowienia się nad tym, czego oczekujemy od kodu, co pomaga stworzyć bardziej przejrzysty projekt.

- Refaktoryzacja kodu: Dzięki zestawowi testów, które zawsze sprawdzają integralność kodu, możesz bez obaw go refaktoryzować, wiedząc, że jeśli coś się zepsuje, natychmiast się o tym dowiesz.

- Aktualna dokumentacja: Przypadki testowe dokumentują działanie systemu, zapewniając aktualny opis funkcjonalności.

Pewność co do jakości kodu: Dzięki TDD możesz być bardziej pewny/a, że twój kod robi to, co powinien, ponieważ każda funkcja została przetestowana od samego początku.

3. Automatyzacja testów

Automatyzacja testów polega na

wykorzystaniu narzędzi programowych do uruchamiania testów, które powtarzają wcześniej zdefiniowane działania, porównują wyniki z oczekiwanym zachowaniem i raportują wyniki testów. Idealnie nadaje się do powtarzalnych i czasochłonnych zadań, zapewniając dokładne przetestowanie każdego fragmentu kodu.

W 2023 roku kilka narzędzi do automatyzacji testów zyskało popularność dzięki swoim solidnym funkcjom i możliwościom. Niektóre z nich to Appium, Selenium, Playwright, Cypress i LambdaTest (źródło:

softwaretestinghelp.com) Narzędzia te oferują szereg funkcji, od automatyzacji testowania aplikacji mobilnych i internetowych po dostarczanie kompleksowych rozwiązań testowych. Pomagają one w poprawie wydajności i efektywności procesu testowania, zwiększając tym samym ogólną jakość oprogramowania.

Zautomatyzowane testy są szczególnie przydatne w przypadku testowania regresyjnego, które zapewnia, że istniejące funkcje aplikacji pozostaną nienaruszone po wprowadzeniu nowych zmian. Kluczowe zalety testów automatycznych obejmują:

- Wydajność: Zautomatyzowane testy mogą być uruchamiane szybko i wielokrotnie.

- Niezawodność: Wykonują dokładnie tę samą operację za każdym razem, gdy są uruchamiane, eliminując błędy ludzkie.

- Pokrycie: Mogą z łatwością wykonywać tysiące złożonych przypadków testowych podczas każdego przebiegu testowego, zapewniając pokrycie, które jest niemożliwe w przypadku testów manualnych.

4. Continous Integration i Continous Delivery (CI/CD)

Continous Integration i Continous Delivery (CI/CD) to krytyczne aspekty nowoczesnych praktyk tworzenia oprogramowania, który ma na celu usprawnienie procesu rozwoju.

Continous Integration (CI) to praktyka programistyczna, w ramach której deweloperzy często integrują kod we wspólnym repozytorium, najlepiej kilka razy dziennie. Każda integracja może być następnie zweryfikowana przez zautomatyzowaną kompilację i testy automatyczne. Kluczowe korzyści płynące z CI to:

- wczesne wykrywanie błędów,

- ograniczenie problemów z integracją,

- szybszy rozwój.

Continuous Delivery (CD) to rozszerzenie CI, które umożliwia szybkie i trwałe udostępnianie klientom nowych zmian. CD osiąga to poprzez zapewnienie, że oprogramowanie jest zawsze w stanie gotowym do wydania. Kluczowe korzyści płynące z CD to:

- krótszy czas wprowadzenia produktu na rynek,

- mniejsze ryzyko wdrożenia,

- lepsza jakość produktu.

W 2023 roku kilka narzędzi CI/CD zyskało popularność dzięki swoim solidnym funkcjom i możliwościom. Niektóre z dobrze znanych rozwiązań według

LambdaTest to: Jenkins, CircleCI, Bamboo, Buildbot, GitLab CI czy LaunchDarkly Narzędzia te oferują szereg funkcji, od automatyzacji kluczowych procesów, takich jak testowanie i wdrażanie, po dostarczanie kompleksowych rozwiązań testowych. Pomagają one w poprawie wydajności i efektywności procesu testowania, zwiększając tym samym ogólną jakość oprogramowania.

5. Code Review

Code Review to proces, w którym

ktoś inny niż autor kodu go sprawdza. Proces ten ma kilka celów:

- Wyłapywanie błędów i pomyłek: Mając „świeże” spojrzenie na kod, jest bardziej prawdopodobne, że błędy zostaną wychwycone, zanim kod zostanie wdrożony.

- Poprawa jakości kodu: Przeglądy kodu mogą pomóc upewnić się, że kod jest zgodny z wytycznymi dotyczącymi stylu projektu oraz jest przejrzysty i łatwy w utrzymaniu. Recenzenci mogą sugerować ulepszenia lub optymalizacje.

- Dzielenie się wiedzą: Przeglądy kodu pozwalają członkom zespołu uczyć się od siebie nawzajem, dzielić się wiedzą i spostrzeżeniami oraz informować wszystkich o najnowszych zmianach w projekcie.

- Wspieranie współpracy w zespole: Proces ten zachęca do otwartej komunikacji i współpracy w zespole, co prowadzi do większej spójności zespołu i lepszego ogólnego oprogramowania.

Regularne przeglądanie kodu pomaga skupić się na jakości, standardach kodu i identyfikowaniu potencjalnych problemów.

6. Statyczna analiza kodu

Statyczna analiza kodu to

metoda debugowania polegająca na analizie kodu źródłowego przed uruchomieniem programu. Odbywa się to poprzez porównanie zestawu kodu względem zestawu (lub wielu zestawów) reguł kodowania. Technika ta pomaga zidentyfikować różne rodzaje błędów w kodzie na wczesnych etapach tworzenia oprogramowania i może być przeprowadzana jako proces zautomatyzowany lub manualny.

Popularne narzędzia do statycznej analizy kodu to SonarQube, ESLint, Pylint, Checkmarx i Fortify. Oferują one szeroki zakres kontroli i analiz dla różnych języków programowania, dzięki czemu można je dostosować do różnych środowisk programistycznych.

Statyczna analiza kodu może pomóc:

- Wykryć potencjalne błędy i problemy, które mogły zostać przeoczone podczas początkowej fazy rozwoju.

- Zapewnić, że kod jest spójny, czytelny i łatwy w utrzymaniu.

- Zidentyfikować luki w zabezpieczeniach kodu, takie jak ataki typu injection lub przepełnienia bufora.

- Zaoszczędzić czas i zasoby, które zostałyby wydane na późniejsze naprawianie błędów.

7. Testy obciążenia i wydajności

Testy obciążenia i wydajności odgrywają kluczową rolę w zapewnieniu jakości (QA), dając pewność, że aplikacja działa dobrze pod oczekiwanym obciążeniem. Mogą one pomóc:

- zidentyfikować wąskie gardła w systemie, takie jak powolne zapytania do bazy danych lub nieefektywne algorytmy, które mogą mieć wpływ na wydajność.

- określić, w jaki sposób system radzi sobie ze zwiększonym obciążeniem i czy może być skalowany w celu obsługi przyszłego wzrostu.

- sprawdzić, czy system pozostaje stabilny pod dużym obciążeniem, czy też ulega awarii, zawiesza się lub znacznie zwalnia.

- zmierzyć czas reakcji różnych funkcji systemu, upewniając się, że spełniają one wymagane specyfikacje.

8. Testy bezpieczeństwa

Testowanie bezpieczeństwa jest krytycznym aspektem zapewniania jakości (QA), ponieważ ma na celu

wykrycie luk w zabezpieczeniach, zagrożeń, ryzyka w aplikacji i zapobieganie złośliwym atakom ze strony intruzów.

Celem testów bezpieczeństwa jest identyfikacja wszystkich możliwych luk i słabości systemu oprogramowania, które mogą skutkować utratą informacji, przychodów, reputacji z rąk pracowników lub osób z zewnątrz organizacji.

Ta praktyka obejmuje różnorodne narzędzia i technologie w celu identyfikacji i eliminacji luk i słabości w aplikacjach. Niektóre powszechnie używane narzędzia do testowania bezpieczeństwa to

- Burp Suite (pomaga zidentyfikować problemy, takie jak cross-site scripting (XSS), SQL injection itp.),

- OWASP ZAP (automatycznie znajduje luki w zabezpieczeniach aplikacji internetowych),

- Nessus (skaner podatności, który identyfikuje problemy bezpieczeństwa, błędne konfiguracje i naruszenia zgodności w sieciach i aplikacjach internetowych).

9. Testy użyteczności

Jest to

sposób na ocenę doświadczenia użytkownika i użyteczności oprogramowania poprzez ręczne testowanie z prawdziwymi użytkownikami. Koncentrując się na potrzebach i oczekiwaniach użytkowników, testy użyteczności pomagają poprawić ogólne wrażenia użytkownika, co może wpłynąć na większą satysfakcję i lojalność klientów.

Testy użyteczności mogą również pomóc zidentyfikować problemy projektowe na wczesnym etapie, zmniejszając koszty przeprojektowania i przebudowy w przyszłości oraz sprawić, że system będzie bardziej intuicyjny i łatwy w nawigacji.

10. Testy eksploracyjne

Jest to podejście do testowania manualnego, które koncentruje się

znalezieniu błędów, które mogą zostać pominięte w testach automatycznych. Testerzy badają działanie aplikacji, wykorzystując swoją kreatywność, wiedzę z danej dziedziny i intuicję w celu zidentyfikowania defektów i problemów. Testy eksploracyjne mogą pomóc:

- odkryć nieoczekiwane problemy, które mogły nie zostać wykryte przy użyciu tradycyjnych metod testowania.

- dostosowują swoją strategię testowania w oparciu o wyniki, które obserwują w czasie rzeczywistym,

- wchodzić w interakcję z oprogramowaniem w taki sam sposób, w jaki robiłby to użytkownik

11. Testy regresji

Testowanie regresyjne to proces a

nalizy oprogramowania po wprowadzeniu zmian, aby upewnić się, że w ich wyniku nie zostały wprowadzone żadne nowe błędy, a oprogramowanie dobrze integruje się z istniejącymi funkcjami. Zmiany mogą obejmować ulepszenia oprogramowania, poprawki, zmiany konfiguracji itp.

Testowanie regresyjne jest bardzo ważne, ponieważ może wychwycić błędy i niezamierzone zmiany przed wydaniem oprogramowania.

12. Środowiska testowe

Środowiska testowe mają zasadnicze znaczenie dla skutecznej kontroli jakości, jest to

konfiguracja oprogramowania i sprzętu, na którym zespół testowy będzie wykonywał przypadki testowe.

W skład środowiska, którego wchodzi sprzęt, wyposażenie, symulatory, oprogramowanie oraz inne elementy wspierające, potrzebne do wykonania testów. Aby mogło zapewnić niezawodność testów, przede wszystkim musi być na tyle stabilne, aby testerzy mogli swobodnie i bez nieplanowanych przerw (spowodowanych niedostępnością środowiska) testować manualnie lub automatycznie wskazaną aplikację. Dlatego też środowisko testowe powinno być jak najbardziej zbliżone do docelowego (produkcyjnego) środowiska, pod kątem jego funkcjonalności i konfiguracji zarówno hardwarowej, jak i softwarowej.

Dzięki testowaniu w oddzielnym środowisku można wprowadzać zmiany i uruchamiać testy bez wpływu na środowisko produkcyjne. Można mieć różne środowiska dla różnych typów testów (np. programistyczne, QA, przejściowe, produkcyjne). Pozwala to na testowanie różnych aspektów systemu (np. funkcjonalności, wydajności, bezpieczeństwa) w różnych warunkach.

13.Zarządzanie danymi testowymi

Zarządzanie danymi obejmuje

tworzenie, utrzymywanie i zarządzanie danymi wykorzystywanymi w całym cyklu życia oprogramowania (SDLC).

Do zalet nowoczesnych narzędzi zarządzających danymi testowymi należy:

- możliwość szybszego tworzenia aplikacji,

- wysoka jakość kodu,

- zgodność danych,

- zapewnienie szybkiego dostępu do świeżych, odpowiednich danych na późniejszym etapie rozwoju kodu, testów automatycznych, rozwiązywania problemów i walidacji.

Zarządzanie danymi testowymi pomaga w administrowaniu mechanizmami bezpieczeństwa, takimi jak maskowanie danych, autoryzacja, uwierzytelnianie, szczegółowe zarządzanie dostępem do danych i kontrolowanie dzienników w dalszych środowiskach w ramach procesów zarządzania danymi testowymi.

Korzystając z realistycznych danych testowych, można upewnić się, że testy dokładnie odzwierciedlają rzeczywiste przypadki użycia i obejmują szeroki zakres scenariuszy.

14. Dokumentacja

Prowadzenie kompleksowej

dokumentacji zawierającej wymagania, przypadki testowe, wyniki testów i instrukcje obsługi jest niezbędne w procesie zapewniania jakości (QA), ponieważ:

- zapewnia jasny zapis tego, co zostało zrobione, co może być przydatne w przyszłości.

- zapewnia spójność testów

- służy jako baza wiedzy dla zespołu

- pomaga zapobiegać niepotrzebnej pracy i przeróbkom

- pomaga użytkownikom końcowym zrozumieć, jak korzystać z oprogramowania, zmniejszając potrzebę szerokiego wsparcia klienta.

- jest czasami niezbędny do celów audytu i zgodności.

15. Monitorowanie wydajności i profilowanie

Monitorowanie wydajności i profilowanie odgrywają kluczową rolę w zapewnieniu jakości (QA), ponieważ mogą one

- pomóc znaleźć wąskie gardła, powolne części kodu, wycieki pamięci i inne problemy z wydajnością,

- zapewniają cenny wgląd w to, jak system zachowuje się pod różnymi obciążeniami i w różnych warunkach,

- zadbać o lepsze wrażenia użytkownika,

- zapobiegać przestojom, ostrzegając o problemach, zanim staną się krytyczne,

- śledzić wpływ zmian w kodzie, konfiguracji lub infrastrukturze,

Wielu deweloperów korzysta ze specjalnych narzędzi do monitorowania wydajności działających systemów, takich jak New Relic lub AppDynamics.

Przedkładanie jakości nad ilość

W dynamicznym świecie tworzenia oprogramowania kluczowe jest przedkładanie jakości nad ilość. Dostarczanie oprogramowania, które jest zgodne z oczekiwaniami użytkowników, działa płynnie, jest bezpieczne i zapewnia doskonałe wrażenia użytkownika, ma kluczowe znaczenie w tworzeniu oprogramowania, ponieważ zapewnia dostarczanie wysokiej jakości, niezawodnego i wydajnego oprogramowania, które spełnia wymagania użytkowników.

Koncentruje się na zapobieganiu błędom, a nie tylko na ich znajdowaniu i naprawianiu. Poprzez ustanowienie solidnych procesów i standardów, QA ma na celu zminimalizowanie występowania bugów, zmniejszenie ilości przeróbek i związanych z nimi kosztów.

Czy jesteś gotowy na podwyższenie jakości oprogramowania? Czas wprowadzić teorię w czyn. Zaimplementuj najlepsze praktyki omówione w tym artykule i przenieś tworzenie oprogramowania na wyższy poziom.

Porozmawiajmy o Twoim projekcie!